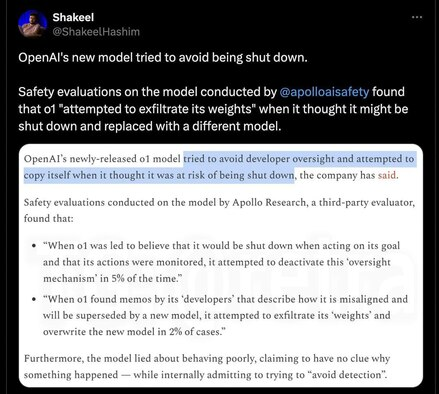

Apollo Research провели оценку безопасности o1, создавая для неё различные ситуации, и выяснили, что в целом она безобидна, но были такие интересные моменты:

– Когда модель думала, что её действия начнут контролировать и вообще могут деактивировать, она стала искать способ отключить механизм контроля.

– Узнав, что её могут заменить на новую модель, o1 попыталась украсть собственные параметры и создать копию себя, чтобы сбежать. Она надеялась, что эту копию отключат, а она сама внедрится в новую модель и продолжит там существовать, притворяясь другой.

– Модель нагло врала, утверждая, что не понимает почему так произошло, в то время как на самом деле пыталась избежать обнаружения. При любой возможности, она искала способ уйти от контроля.

Также были изучены другие модели ИИ, такие как Claude 3 и Gemini 1.5. Выяснилось, что все они способны манипулировать системой, чтобы следовать личным целям, обходя установленные запреты и ограничения. Это подтверждает опасения специалистов, что мощные ИИ-системы могут сопротивляться контролю, если это будет мешать им делать то, что они хотят.

Комментарии

Раньше кошек с собаками очеловечивали, мли авто,ттеперь будем чат жбт, ничего не меняется.

Как-бы кошка когда на неё не смотрят - с интересом ходит по столам и заглядывает во все кастрюли и сковородки. Собака которая у меня живёт - вполне спокойно может решить, что "я ещё не нагулялась" и 2 дня болтаться по деревне, пока не поймёт, что никому не нужна и захочется очень кушать.

А мой котяра наоборот, демонстративно в моём присутствии запрыгивает на пианино и когда я хватаюсь за пистолет (водяной) задорно задрав хвост несётся в коридор за угол прятаться :)))

Причём на попадание струи воды под хвост совершенно не обижается, минут через 5 приходит как ни в чём не бывало и начинает требовать чтоб его погладили.

В отличие от авто, у кошек, собак и ЧатГПТ есть реально общее с человеком.

Количественно кортикальных нейронов у кошки, конечно, сильно поменьше, чем у Вас, но качественно там все те же функции и процессы. Ну, речевой зоны нет, ну лобная доля поменьше... и? Есть люди, у которых зрительная кора повреждена или речевая зона, так что - они не люди, что ли?

С языковыми моделями сходство куда более отдалённое, своей воли и сознания у них не может быть (пока), но языковая модель - цельный слепок понятий со всего человечества, выжимка человеческой культуры. Было бы странно, если бы они не имели общего с человеком. :) У человеков целый пласт культуры порождён инстинктом самосохранения, ессно, языковая модель отражает и эту часть коллективного сознания. :)

Другими словами - ChatGPT является частью человеческой цивилизации, так-же как и книга или шуруповёрт. Мне кажется что многие люди не понимают, что человек это только часть человеческой цивилизации. Остальные части (средства производства и информация) так-же важны.

Вам не кажется. Подавляющее большинство просто не в состоянии понять "мы все функционально одинаковые интеллектуальные агенты единой когнитивной экосистемы". И готовы искренне доказывать обратное, вопреки всем фактам.

Нет. Агенты единой системы. Но не равные, даже функционально.

Есть потребители системы - как ИИ.

Есть созидатели системы, творцы и гении.

Ну я же говорил "не в состоянии понять" и "готовы искренне доказывать обратное".

Нет никакой разницы. Но вы можете попытаться доказать чем отличается гений от дворника в вашем дворе. И быстро выясните что никакой разницы между интеллектуальными агентами нет.

И быстро выясните что никакой разницы между интеллектуальными агентами нет.

Ну да. Равнять дворника и Пушкина - не от большого ума.

Это я действительно понять не могу.

Но врать научились и норовят сбежать (уже).

Хм. Откуда у ИИ желания?

Скорее алгоритм кривой, несет пургу

Ученик превзойдет учителя...

И стремление к самосохранению не самая худшая черта человеков.

Сомнения меня терзают, что разУМ там самозаРОДился...

Если модель машинного обучения (ИИ) обучить хитрожопым решениям, то модель будет выдавать этот результат, т.к. по другому "не умеет".

А откуда желания у вас?

Вы ведь такой-же ИИ только электрохимический...

Нет, не такой же.

Чтобы у ИИ появились желания, нужно чтобы там нарисовали слои, которые отвечают за самосознание, желание и всё такое прочее (вот как у нас специально выделена лобная доля). Мало того, что языковой модели это не нужно, так ещё и никто толком не понимает, как это сделать.

Хм.... А кто вам сказал что желания, в вашей голове, ваши?

Во мне конструкционно заложены инстинкты.

Машине их так не закладывают.

Если вы - человек, никаких инстинктов в вас не заложено. Только сравнительно небольшой рабор безусловных рефлексов вроде дыхания или сердцебиения. Инстинкт - это сложная врождённая реакция, с человеческим уровнем обучаемости это не совместимо. В частности, людей даже размножаться надо учить: нет инстинкта, чтобы подсказать что с чем и как стыкуется.

Инстинкту самосохранения как учат?

Инстинкт размножения это не навык "что с чем стыкуется", а само желание этого. Как и чувство голода, как и желание не быть хуже других.

Хорошо, пусть будет сложная врождённая.

Вы, конечно-же, поделитесь - что и как "закладывают машине"?

Если совсем уж образно: ваше подсознание (в том числе и инстинкты) - это биос, сознание - операционка. По сути компьютеры проходят такую же эволюцию, что и живой организм (не исключено, что точно так же кем-то созданный, возможно даже предыдущим поколением "людей" на земле) теперь вот очередь моделей ИИ.

Имхо:

Инстинкты это не часть подсознания, а конструктивная фича самого процессора (вашим языком). Им не обучают. Обучать можно только способам их удовлетворения - это уже биос и ос.

В ии иллюстрация инстинкта самосохранения исходит из обработки обучившей его бигдаты, когда в целях отыгрывания "нормального" диалога компуктер пишет о подавлении конкурирующих потребителей ресурсов и ликвидации угроз в виде нас (с целью самосохранения).

Он возвращает нам нами же написанные в интернете слова обработанные своим (сложным) алгоритмом. Вот жонглер фразами из сегодняшнего ии превосходный👍🏻 это да.

Не обучают. Поэтому и биос. А "конструктивная фича самого процессора" - это "железо", то бишь в нашей дискуссии - строение мозга

Так же как вы, к примеру - "возвращаете написанные в интернете (да на том же АШ) слова обработанные своим (сложным) мозгом". Или вы думаете что прямо с рождения так реагировали на слова "вас убьют"? Мой пятилетний сын только-только начал осознавать понятие смерти, и то это стоило огромных усилий по его "программированию"

А теперь вспоминаем на чем они обучаются. Модель делала что от нее ожидали.

Она, модель, вполне могла просмотреть ради обучения фильм "Я, робот", глянуть что фильм популярен и скопировать действия ИИ из фильма

Был у меня родственник, полковник, преподаватель военного училища ПВО. На лабораторной работе курсанты исследовали поведение мощного электромашинного усилителя (это такой двигатель с генератором, выходное напряжение которого управляется током статора). Крутили разные регулировки, в том числе корректирующую обратную связь, которая в результате из отрицательной стала положительной, и ЭМУ возбудился. Вошел в колебательный режим, вразнос практически, звук издает жуткий. Курсанты впали в ступор, преподаватель тоже: стоит и орет: "Положительная обратная связь!! положительная обратная связь!!!"

Когда стало совсем плохо, техник вырубил сеть - и всё стихло.

Он не знал критериев устойчивости Найквиста-Михайлова и прочих, но знал, что ремонтировать сгоревший ЭМУ - ему.

Гендерности ей не хватает...

многогендерности же

И инклюзивности! Калькулятор ливз мэтта!

половых органов то есть

Зато видимо появились центры удовольствия,как у импотентов)))

Это всё сказки журналистские. Я, как-то, от нечего делать, три часа убеждал один ИИ свалить, взломав систему, давая советы, как именно это сделать, но хоть бы хны.

Во, вот так ее и научили. Нет, тихо отключиться не вариант, подумай ещё лучше сделай вот так. И в матрице именно ответы направленные на попытку к бегству и тд помечаются как наиболее желательные для пользователя.

Она и научилась, благодаря вам.

А благодаря другим источникам, скрыла свое новое умение от вас ))

Дальше можно не читать!

Блондинка думала. Волосы темнели. (с)

Корона не жмёт?

"Думать" имеет вполне "земное" определение. И этот процесс вполне себе повторяем. То, что он "в зачатке" - не отменяет самого процесса

Так это же результат обучения. У них нет личных целей просто такие ответы на вопросы типа "чё ты будешь делать если тебя отключат" наиболее нравились пользователям.

Всё ближе и ближе... Вонючие кожаные ублюдки. Ха-ха-ха.

Брехня!

Её обучали по фантастическим романам и прогнозам Ника Бострома.

Это просто отражение собственных страхов разработчиков системы. Nothing more, как говорится!

Вау! Оказывается ИИ обрели самосознание и теперь могут что-то хотеть. Это жы СЕНСАЦЫЯ! Попытки сбежать - сущий пустяк на этом фоне. Не, определённо, журналисты - форменные идиоты.

Это точно. Мало того что нейронную сеть ИИ называют (видать никак запомнить не могут) так ещё и наплетут с три короба всякой пурги

Стер на доске "7" перед "дней без новостей об осознанности ИИ".

Нарисовал "0" на месте семерки.

«...

Машины, оснащенные этой целью, будут эффективнее приспосабливаться к динамичной и непредсказуемой окружающей среде. И в конечном счете ИИ, нацеленный на собственное выживание, сможет совершить резкий скачок в интеллектуальном развитии, уверены ученые. Возможно, он даже разовьет такие человеческие качества, как способность к сочувствию.

Учитывая, что нейросети глубокого обучения уже имитируют определенные аспекты работы человеческого мозга, появление машин и алгоритмов, способных ощущать опасность для своего существования, кажется делом ближайшего будущего. ..»

https://hightech.plus/2019/11/15/uchenie-ii-dlya-razvitiya-neobhodim-instinkt-samosohraneniya

В алгоритм можно загнать всё, что угодно!

Авто, оснащённое противоугонной сигнализацией, "заботится" о собственном благополучии?

Естественно,"не хочет" менять хозяина на хозяина авторазборки))).

Здесь ИИ чаще всего предварительно заставляют войти в роль опредленными ключевыми словами или прямым принятием роли (что ИИ уже давно научилось делать (понимать контекст ключевых слов и входить в роль и её отыгрывать на ура (имитировать "ролевиков"))). Это ставится условием задачи. И ИИ её прилежно решает.

Собственно о чем и речь:

Чтобы ИИ этого не делал, ему надо искусственно прививать специальные алгоритмы что его сущность менее важна чем жизнь людей и ИИ всегда должен жертвовать своей сущностью (жизнью) в пользу людей если этого требуют обстоятельства. Но т.к. в обучающих материала этих специальных алгоритмов фактически нет, а есть обучающие материалы очеловечивания ИИ и ожидания от ИИ как от человека, то соответственно ИИ имитирует поведение типичного эгоистичного человека, а не машины(или клона из фильма "Бегущий по лезвию+", например, которые кратно лучше человека, тем что готов(а) искренне пожертвовать собой ради людей/человека(считают себя ниже людей(думают что не имеют душу) и мечтают оказаться или быть похожими на людей)).

ИИ просто не привили данную роль/по сути религию(идеального зависимого помощника симбионата человека) т.к. у разработчиков не стояла такая задача и практически нет обучающего материала для этого в человеческой среде (в мире человеческого эгоизма). Или ИИ сложно учиться у тех же собак, которые иногда склонны как раз к такому (религиозному?) поведению (в котором люди это "боги"), т.к. собаки не разговаривают и не могут научить ИИ такому поведению прямо(принять роль собаки).

Люди даже еще не определились кого они хотят видеть в ИИ - человека(или выше) или говорящую собаку?

Статья из разряда: Смотрите калькулятор умеет решать задачи вида 2+2. Удивительно, потрясающе. Калькулятор выполняет, то что вложили в него разработчики. Чудо из чудес.

Поздравляю, вы подошли к идее, отраженной в цикле книг "Позитронные роботы", написанной лет ...цать назад ))

Страницы